Kurz & Knapp: Das erwartet dich in diesem Artikel

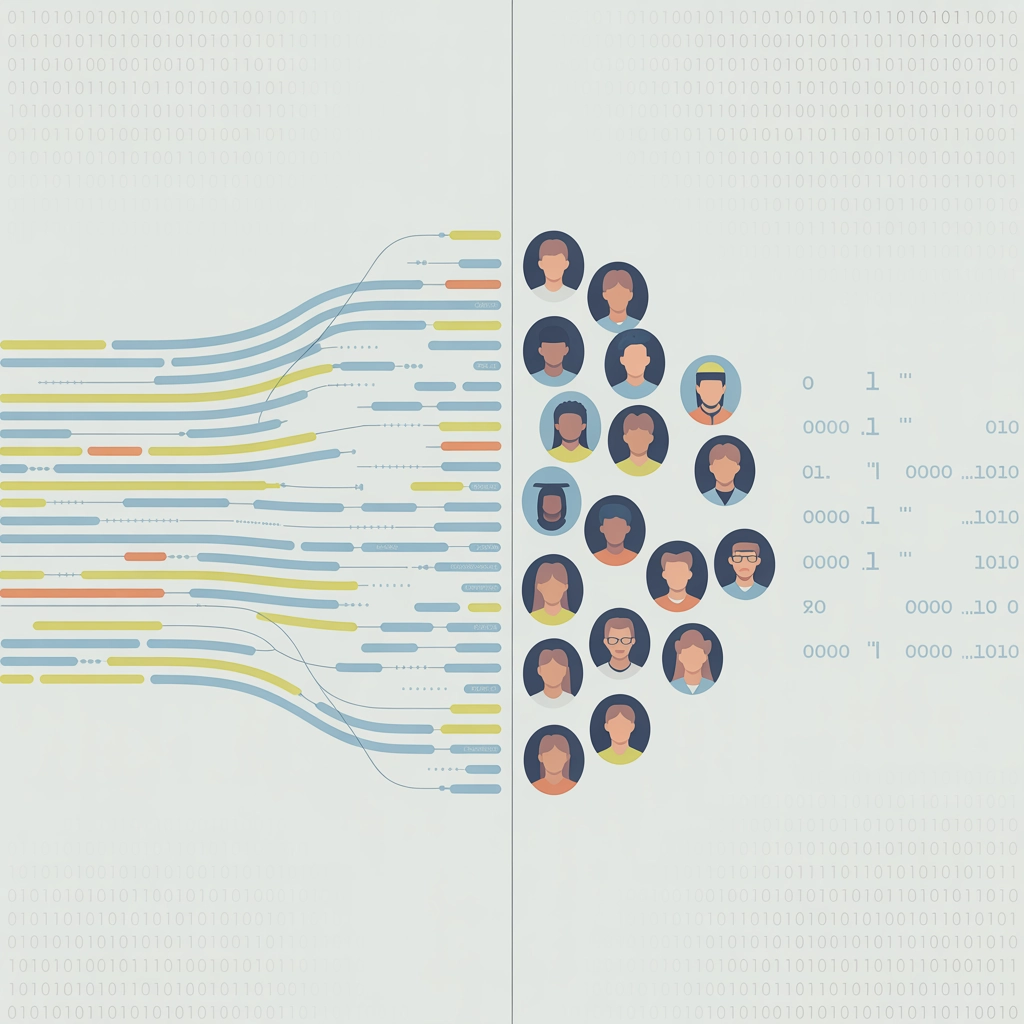

Wir alle nutzen KI-Systeme fast täglich – von Suchmaschinen über Sprachassistenten bis hin zu Social Media Feeds. Doch wusstest du, dass diese Systeme oft voreingenommen sind und bestimmte Gruppen benachteiligen können? In diesem Artikel tauchen wir tief in die Welt des KI-Bias ein, zeigen dir anhand krasser Beispiele, warum das ein echtes Problem ist, und welche Lösungen es gibt. Du erfährst, warum verzerrte Trainingsdaten und fehlende Diversität zu diskriminierenden Ergebnissen führen und wie wir als Tech-Community daran arbeiten können, KI fairer zu machen.

Was ist KI-Bias überhaupt?

Stell dir vor, du hast eine KI, die eigentlich neutrale Entscheidungen treffen soll – zum Beispiel bei Bewerbungen, Kreditvergaben oder sogar vor Gericht. Doch stattdessen bevorzugt sie systematisch bestimmte Gruppen, während andere benachteiligt werden. Genau das ist KI-Bias: eine unbeabsichtigte, aber reale Diskriminierung durch algorithmische Systeme.

Aber wie entsteht sowas? Im Kern geht es um die Daten, mit denen wir KIs füttern:

„KI-Systeme sind nur so objektiv wie die Daten, mit denen sie trainiert werden. Wenn diese Daten historische Ungleichheiten widerspiegeln, werden diese in den Algorithmen verewigt.“

Die häufigsten Ursachen für KI-Bias

- Verzerrte Trainingsdaten: Der absolute Klassiker! Wenn eine Recruiting-KI mit Bewerbungsdaten trainiert wird, in denen überwiegend Männer Führungspositionen innehatten, wird sie logischerweise männliche Kandidaten bevorzugen. Die KI „lernt“ dann nicht objektive Qualifikation, sondern reproduziert historische Muster.

- Unrepräsentative Datensätze: Gesichtserkennungs-KIs wurden lange Zeit hauptsächlich mit Bildern weißer Menschen trainiert. Das Ergebnis? Die Fehlerrate bei der Erkennung von Menschen mit dunkler Hautfarbe war bis zu 34% höher. Autsch!

- Mangelnde Diversität in Entwicklungsteams: Wenn nur eine homogene Gruppe (beispielsweise junge, weiße Männer) an KI-Systemen arbeitet, bleiben blinde Flecken unvermeidlich. Was für die eine Gruppe selbstverständlich ist, kann für andere problematisch sein.

- Selection Bias: Die ausgewählten Daten repräsentieren nicht die Gesamtpopulation. Ein Beispiel: Wenn medizinische KIs hauptsächlich mit Daten von Patienten aus wohlhabenden Gegenden trainiert werden, können sie für ärmere Bevölkerungsgruppen mit anderen Gesundheitsprofilen ungeeignet sein.

Wie wir in unserer Nerdoase-Videoserie zu ethischen Tech-Fragen ausführlich diskutiert haben, ist das Problem nicht die KI selbst – sondern wie wir Menschen sie gestalten und einsetzen.

Real Talk: Diese krassen Beispiele zeigen das Problem

Der Amazon-Recruiting-Skandal

2018 machte Amazon Schlagzeilen, als bekannt wurde, dass ihr KI-gestütztes Recruiting-Tool Frauen systematisch benachteiligte. Die KI hatte aus historischen Bewerbungsdaten „gelernt“, in denen Männer überwiegend technische Positionen innehatten. Das Ergebnis? Die KI bewertete Lebensläufe mit Hinweisen auf das weibliche Geschlecht (wie „Frauenschachclub“ oder „Frauencollege“) automatisch schlechter.

Amazon musste das Tool zurückziehen. Ein teurer Fehler, der aber wichtige Erkenntnisse lieferte.

Voreingenommene Gesundheits-KIs

Ein besonders gefährlicher Bereich für KI-Bias ist die Medizin. Studien haben gezeigt, dass Algorithmen zur Priorisierung von Patienten für zusätzliche medizinische Betreuung systematisch weiße Patienten bevorzugten – selbst wenn schwarze Patienten kränker waren. Warum? Die KI nutzte Gesundheitskosten als Proxy für den Bedarf an Betreuung, und aufgrund struktureller Ungleichheiten gaben schwarze Patienten historisch weniger für Gesundheitsversorgung aus.

Predictive Policing und Justiz

In der Strafverfolgung setzen viele Behörden auf „Predictive Policing“ – KI-Systeme, die vorhersagen sollen, wo Verbrechen wahrscheinlich stattfinden werden. Das Problem: Diese Systeme werden mit historischen Polizeidaten trainiert, die bereits Vorurteile enthalten können.

Ein bekanntes Beispiel ist COMPAS, ein in US-Gerichten eingesetzter Algorithmus zur Risikobewertung von Straftätern. Eine ProPublica-Untersuchung zeigte, dass das System schwarze Angeklagte mit doppelt so hoher Wahrscheinlichkeit fälschlicherweise als Hochrisiko einstufte wie weiße Angeklagte.

Die gesellschaftlichen Folgen von KI-Bias

Die Auswirkungen von voreingenommenen KI-Systemen gehen weit über einzelne falsche Entscheidungen hinaus:

- Verstärkung bestehender Ungleichheiten: KI-Systeme können wie ein Vergrößerungsglas wirken, das bestehende Diskriminierung nicht nur reproduziert, sondern sogar verstärkt.

- Erschwerter Zugang zu Ressourcen: Wenn KIs über Kredite, Jobs oder Wohnungen entscheiden, können sie systematisch bestimmten Gruppen den Zugang erschweren.

- Untergrabenes Vertrauen in Technologie: Mit jedem bekannt gewordenen Bias-Fall sinkt das Vertrauen in KI-Systeme – gerade bei den betroffenen Gruppen.

- Fehlende Transparenz: Viele KI-Systeme sind „Black Boxes“ – selbst ihre Entwickler können oft nicht genau erklären, wie bestimmte Entscheidungen zustande kommen.

Wie wir in unserem Nerdoase-Artikel zur Zukunft der KI-Regulierung ausführlich diskutiert haben, brauchen wir dringend klare Regeln und ethische Leitlinien.

So können wir das Problem lösen

Die gute Nachricht: Es gibt konkrete Lösungsansätze, an denen bereits gearbeitet wird:

Technische Lösungen

- Diverse Trainingsdaten: KI-Entwickler müssen aktiv daran arbeiten, repräsentative und ausgewogene Datensätze zu erstellen.

- Bias-Audits: Regelmäßige Tests können helfen, Voreingenommenheit in KI-Systemen zu identifizieren, bevor sie in die Praxis gehen.

- Explainable AI (XAI): Statt undurchsichtiger „Black Box“-Modelle brauchen wir KIs, deren Entscheidungen für Menschen nachvollziehbar sind.

Organisatorische Maßnahmen

- Diverse Teams: Die Zusammensetzung von KI-Entwicklungsteams sollte die Vielfalt der Gesellschaft widerspiegeln.

- Ethik-Boards: Unabhängige Gremien können KI-Systeme vor ihrer Einführung auf ethische Probleme prüfen.

- Regelmäßiges Bias-Training: Entwickler müssen für das Thema sensibilisiert werden und lernen, wie sie Voreingenommenheit erkennen und vermeiden können.

Regulatorische Ansätze

- EU AI Act: Die EU arbeitet an einem umfassenden Regelwerk für KI, das risikobasierte Ansätze und strenge Auflagen für Hochrisiko-Anwendungen vorsieht.

- Algorithmic Impact Assessments: Ähnlich wie Umweltverträglichkeitsprüfungen könnten diese vorgeschrieben werden, bevor KI-Systeme in sensiblen Bereichen eingesetzt werden.

- Transparenzpflichten: Unternehmen könnten verpflichtet werden, offenzulegen, wie ihre KI-Systeme funktionieren und welche Daten sie nutzen.

Was kannst du tun?

Auch als einzelne:r Tech-Enthusiast:in oder Entwickler:in kannst du etwas bewirken:

- Bewusstsein schaffen: Sprich über das Thema KI-Bias in deinem Umfeld und teile Wissen.

- Bei eigenen Projekten mitdenken: Achte bei eigenen KI-Projekten von Anfang an auf potenzielle Bias-Quellen.

- Diversität fördern: Unterstütze Initiativen, die mehr Diversität in die Tech-Branche bringen.

- Kritisch bleiben: Hinterfrage KI-Entscheidungen und fordere Transparenz von Unternehmen und Institutionen.

Fazit: KI kann fair sein – wenn wir es wollen

KI-Bias ist kein technisches Problem, sondern ein menschliches. Die gute Nachricht: Was Menschen verursachen, können sie auch lösen. Durch bewusstes Design, diverse Teams und klare ethische Leitlinien können wir KI-Systeme entwickeln, die fair und gerecht entscheiden.

Wie bei jeder mächtigen Technologie liegt es an uns, KI verantwortungsvoll zu gestalten. Und genau darum geht es auch in unseren Nerdoase-Videos und Artikeln: Technologie zu verstehen und so zu gestalten, dass sie allen nutzt.

Hast du selbst Erfahrungen mit KI-Bias gemacht oder arbeitest du an Lösungen? Teile deine Gedanken in den Kommentaren oder schreib uns auf unseren Social-Media-Kanälen. Lass uns gemeinsam dafür sorgen, dass die KI-Revolution niemanden zurücklässt!

PS: Schau dir auch unsere YouTube-Serie zu KI-Ethik an, in der wir dieses und verwandte Themen noch tiefer beleuchten und mit Experten diskutieren.

Schreibe einen Kommentar