Was erwartet dich in diesem Artikel? Wir tauchen tief ein in die technische Revolution der Wettervorhersage: Von Graph Neural Networks über Transformer-Architekturen bis hin zu Diffusionsmodellen. Du erfährst, wie Google DeepMind, Huawei und NVIDIA die Meteorologie auf den Kopf stellen – und warum ein KI-Modell in unter einer Minute schafft, wofür Supercomputer Stunden brauchen. Schnall dich an für einen echten Nerd-Trip durch ERA5-Datensätze, Navier-Stokes-Gleichungen und probabilistische Ensembles!

Mehr spannende Tech-Themen findest du übrigens in der Tech-Kategorie meines Blogs und auf meinem YouTube-Kanal @nerdoase, wo ich regelmäßig KI- und Tech-Videos veröffentliche.

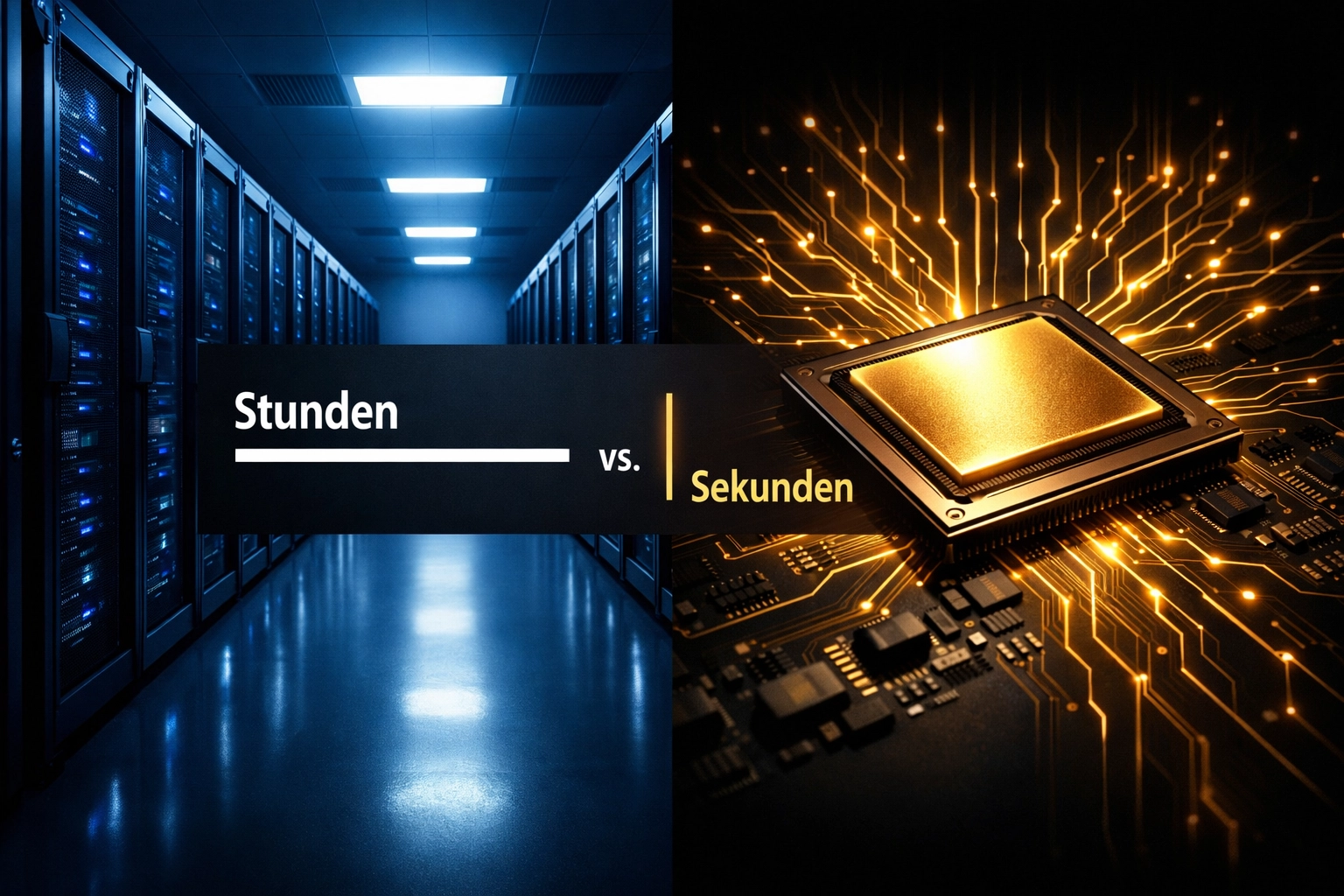

Das Ende der Supercomputer-Ära? Traditional NWP vs. KI-Modelle

Seit Jahrzehnten basiert die Wettervorhersage auf Numerical Weather Prediction (NWP) – einem Verfahren, das die Atmosphäre in ein dreidimensionales Gitter zerlegt und für jeden Gitterpunkt die fundamentalen physikalischen Gleichungen löst. Im Zentrum stehen die Navier-Stokes-Gleichungen, die Strömungsdynamik, Thermodynamik und Strahlungstransport beschreiben.

Das Problem? Diese Gleichungen sind extrem komplex und müssen für Millionen von Datenpunkten in winzigen Zeitschritten berechnet werden. Das bedeutet: Supercomputer im Wert von mehreren hundert Millionen Euro laufen stundenlang, um eine 10-Tage-Prognose zu erstellen. Der Energieverbrauch ist enorm, die Rechenzeit begrenzt die Reaktionsfähigkeit bei plötzlichen Wetteränderungen.

KI-Modelle drehen diesen Ansatz um: Statt physikalische Gleichungen zu lösen, lernen sie aus 40 Jahren historischer Wetterdaten, wie sich atmosphärische Muster entwickeln. Das Resultat ist verblüffend: Was ein Supercomputer in Stunden schafft, erledigt ein trainiertes KI-Modell auf einer einzelnen Google TPU in unter einer Minute – bei 1000-fach geringerem Energieverbrauch.

Die Giganten der KI-Meteorologie

GraphCast (Google DeepMind): Die Macht der Graph Neural Networks

GraphCast von Google DeepMind ist aktuell der Platzhirsch und nutzt Graph Neural Networks (GNNs) als Kernarchitektur. Aber was macht GNNs so besonders für die Meteorologie?

Die technische Idee: Die Erdoberfläche wird als gigantisches Netzwerk aus über 1 Million Datenpunkten modelliert. Jeder dieser Knoten repräsentiert einen Ort auf der Erde und ist mit seinen Nachbarn verbunden. An jedem Knoten werden 5 Oberflächenvariablen (Temperatur, Windgeschwindigkeit, Luftdruck, Niederschlag, Luftfeuchtigkeit) sowie 6 atmosphärische Variablen für 37 verschiedene Höhenstufen berechnet.

GNNs sind perfekt geeignet für diese Aufgabe, weil sie darauf spezialisiert sind, Beziehungen und Abhängigkeiten zwischen Knoten zu lernen. Das Netzwerk versteht: Wenn sich die Temperatur über dem Atlantik ändert, wie beeinflusst das wahrscheinlich das Wetter in Europa drei Tage später? Diese räumlich-temporalen Abhängigkeiten sind das Herzstück der Wettervorhersage.

Das Multiskalen-Mesh: GraphCast verwendet ein hierarchisches Gitter mit unterschiedlicher Auflösung. In Regionen mit komplexem Terrain (Gebirge, Küsten) ist das Netz feiner, über offenen Ozeanen gröber. Das spart Rechenleistung, ohne Genauigkeit zu opfern.

Die Zahlen sprechen für sich: GraphCast übertrifft das HRES-Modell des Europäischen Zentrums für mittelfristige Wettervorhersage (ECMWF) – das als Goldstandard gilt – in über 90% der getesteten Variablen und Vorhersagehorizonte. Besonders beeindruckend: Bei der Vorhersage von Hurrikan Lee lag GraphCast neun Tage im Voraus richtig, drei Tage früher als traditionelle Modelle.

Pangu-Weather (Huawei): 3D-Transformer und hierarchische Zeitschritte

Huaweis Pangu-Weather nimmt einen anderen technischen Ansatz und setzt auf 3D-Transformer-Architekturen. Transformer kennt man vor allem aus der Sprachverarbeitung (GPT, BERT), aber sie funktionieren überall dort brillant, wo es um Aufmerksamkeitsmechanismen geht.

Die Besonderheit: Pangu-Weather nutzt einen hierarchischen Ansatz mit verschiedenen Zeitschritten. Für kurzfristige Vorhersagen (1–3 Tage) werden kürzere Zeitintervalle verwendet, für langfristige Prognosen (7–10 Tage) größere Schritte. Das Modell lernt, welche atmosphärischen Features für welchen Zeithorizont relevant sind.

Die 3D-Struktur berücksichtigt gleichzeitig die horizontale Ausdehnung (Längen- und Breitengrad) und die vertikale Schichtung der Atmosphäre. Der Transformer-Mechanismus ermöglicht es dem Modell, globale Abhängigkeiten zu erfassen: Wie beeinflusst ein El Niño im Pazifik das Wetter in Afrika?

FourCastNet (NVIDIA): Adaptive Fourier Neural Operatoren

NVIDIA geht mit FourCastNet einen mathematisch eleganten Weg über Adaptive Fourier Neural Operators (AFNO). Hier wird die Wettervorhersage als Operator-Lernproblem formuliert.

Die Idee: Statt direkt Wettervariablen zu prognostizieren, lernt das Modell den Operator – die mathematische Funktion, die den aktuellen Zustand in den zukünftigen Zustand überführt. Fourier-Transformationen erlauben es, komplexe räumliche Muster effizient im Frequenzraum zu verarbeiten.

Der Vorteil: AFNO ist extrem skalierbar und kann mit hochauflösenden Daten (0,25° Gitterweite) arbeiten, ohne dass die Rechenkosten explodieren. Das macht besonders detaillierte regionale Vorhersagen möglich.

Die Datenbasis: ERA5 und das Training der Modelle

Alle diese KI-Systeme teilen eine gemeinsame Grundlage: den ERA5-Datensatz des ECMWF. ERA5 ist eine Reanalyse von 40 Jahren (1979–heute) globaler Wetterdaten mit stündlicher Auflösung. Er kombiniert:

- Satellitenmessungen

- Radar- und Bodenstationen

- Atmosphärische Messungen von Wetterballons

- Ozeanische Bojen

- Flugzeugdaten

Dieser Datensatz umfasst mehrere Petabyte und ist das "ImageNet der Meteorologie" – die ultimative Trainingsbasis für KI-Modelle. Die Modelle lernen aus Milliarden von Beispielen, wie sich Wettersysteme entwickeln, ohne dass man ihnen die Physik explizit programmieren muss.

Der Trainingsaufwand: Ein Modell wie GraphCast zu trainieren erfordert Wochen auf leistungsstarken GPU-Clustern und kostet mehrere Millionen Euro an Rechenleistung. Aber: Ist das Modell einmal trainiert, läuft die Inferenz (die eigentliche Vorhersage) extrem effizient.

Technische Funktionsweise: Autoregressive Modelle und Zeitschritte

KI-Wettermodelle arbeiten autoregressiv: Sie nehmen den aktuellen Zustand der Atmosphäre als Input und berechnen den Zustand für den nächsten Zeitschritt (typischerweise 6 Stunden später). Dieser vorhergesagte Zustand wird dann als Input für den übernächsten Zeitschritt verwendet – und so weiter.

Der Prozess im Detail:

- Input: Der aktuelle atmosphärische Zustand als multidimensionaler Tensor (räumliche Koordinaten × atmosphärische Variablen × Höhenschichten)

- Encoder: Das Modell komprimiert diese Information in eine latente Repräsentation

- Processor: GNN/Transformer lernt die zeitliche Entwicklung

- Decoder: Die latente Repräsentation wird zurück in den physikalischen Raum projiziert

- Output: Der vorhergesagte atmosphärische Zustand 6 Stunden später

Diese Schritte werden iterativ wiederholt. Nach 40 Iterationen hat man eine 10-Tage-Prognose – alles in unter einer Minute.

Probabilistische Vorhersagen: Google SEEDS und Diffusionsmodelle

Ein großer Nachteil deterministischer Vorhersagen: Sie liefern nur eine einzige Zukunft, ohne Unsicherheit zu quantifizieren. In der Realität gibt es aber immer Unsicherheiten, besonders bei längeren Vorhersagezeiträumen.

Ensemble-Vorhersagen lösen dieses Problem, indem sie Hunderte leicht unterschiedlicher Simulationen durchführen. Traditionell ist das extrem teuer – jede Simulation braucht Stunden Supercomputer-Zeit.

Google hat mit SEEDS (Scalable Ensemble Envelope Diffusion Sampler) einen cleveren Ansatz entwickelt: Diffusionsmodelle (wie sie bei Bild-KIs zum Einsatz kommen) erzeugen probabilistische Wettervorhersagen. Statt einen festen Zustand vorherzusagen, sampelt das Modell aus einer Wahrscheinlichkeitsverteilung möglicher Zukünfte.

Der Vorteil: Man erhält nicht nur die wahrscheinlichste Entwicklung, sondern auch die Bandbreite möglicher Szenarien – essenziell für Risikoabschätzung bei Extremwetter. Und das Ganze läuft immer noch in Minuten statt Tagen.

Warum NWP noch nicht tot ist – und die Zukunft der Vorhersage

Trotz aller Erfolge: KI-Modelle haben Schwächen. Als Hurrikan Otis 2023 überraschend schnell an Kraft gewann, versagten sie genauso wie traditionelle Modelle. Der Grund: Extrem schnelle, nicht-lineare atmosphärische Phänomene sind selten in den Trainingsdaten und werden daher schlecht vorhergesagt.

Physik-Garantie vs. Statistik: NWP-Modelle respektieren immer die fundamentalen physikalischen Gesetze (Energieerhaltung, Massenerhaltung). KI-Modelle können theoretisch "halluzinieren" und physikalisch unmögliche Zustände vorhersagen, wenn sie auf Situationen treffen, die nicht in den Trainingsdaten vorkamen.

Die Zukunft liegt wahrscheinlich in hybriden Systemen: KI übernimmt die schnelle, effiziente Standardvorhersage, während physikbasierte Modelle für Extremsituationen und zur Validierung einspringen. Erste Experimente mit physikalisch informierten neuronalen Netzen (PINNs) zeigen vielversprechende Resultate.

Übrigens: Wenn du selbst mit KI experimentieren möchtest – sei es für Wetteranalysen, Content Creation oder andere Projekte – schau dir Marblism an. Mit dem Code "Nerdoase" bekommst du 25% Rabatt! KI-Agenten machen deine Zeit beim Erstellen von Blogs, Social-Media-Beiträgen und Projekten zum absoluten Paradies.

Quellen und weiterführende Literatur

- Google DeepMind Blog: "GraphCast: AI model for faster and more accurate global weather forecasting" (2023)

- Science: Lam, R. et al. "Learning skillful medium-range global weather forecasting" (2023)

- Nature: Bi, K. et al. "Accurate medium-range global weather forecasting with 3D neural networks" – Pangu-Weather Paper (2023)

- ECMWF Website: ERA5 Dataset Documentation (climate.copernicus.eu)

- NVIDIA Technical Blog: "FourCastNet: Accelerating Global High-Resolution Weather Forecasting" (2022)

- Google Research: "SEEDS: Emulation of Weather Forecast Ensembles with Diffusion Models" (2024)

Mehr zur Nutzung von KI in verschiedenen Bereichen findest du in meiner KI-News-Kategorie – von praktischen Tools bis zu den neuesten Entwicklungen!

Schreibe einen Kommentar