Einleitung: Von Text zu Track in Sekunden

Stell dir vor, du tippst ein paar Worte ein – und Sekunden später erklingt ein komplett neuer Song, der klingt, als hätte ihn eine Band im Studio aufgenommen. Was nach Science-Fiction klingt, ist mit KI-Tools wie Suno längst Realität. In diesem Deep Dive erklären wir dir Schritt für Schritt, wie diese faszinierende Technologie funktioniert – vom einfachen Textprompt bis zum fertigen Track. Du erfährst, welche komplexen Prozesse im Hintergrund ablaufen und welche technischen Innovationen dahinterstecken. Perfekt für alle Nerds, die verstehen wollen, wie Künstliche Intelligenz zur Musikproduktion eingesetzt wird!

1. Prompt-Verarbeitung: Wie Sprache zum Musikbauplan wird

Der erste Schritt bei Suno ist die Eingabe eines Textprompts – quasi deine Bestellung an die KI. Du könntest zum Beispiel eingeben: „Ein melancholischer Synthwave-Track mit 80er-Vibes und kraftvollem weiblichen Gesang über künstliche Intelligenz.“ Was passiert dann?

Sprachmodell entschlüsselt deine Absicht

Suno nutzt ein fortschrittliches Sprachmodell (ähnlich wie GPT-4), das deinen Text analysiert und in seine Bestandteile zerlegt:

- Genre-Erkennung: „Synthwave“ → elektronische Musik mit retro Charakter

- Stimmungsanalyse: „melancholisch“ → Moll-Tonarten, langsames bis mittleres Tempo

- Instrumentierung: „80er-Vibes“ → typische Synthesizer jener Ära

- Gesangsart: „kraftvoller weiblicher Gesang“ → bestimmte Stimmcharakteristik

- Thematische Ausrichtung: „über künstliche Intelligenz“ → Inhalt für Lyrics

Das System tokenisiert dabei deinen Text (zerlegt ihn in kleinste bedeutungstragende Einheiten) und ordnet diese Tokens musikalischen Konzepten zu.

Von Worten zu musikalischen Parametern

Im nächsten Schritt werden diese erkannten Konzepte in konkrete musikalische Parameter übersetzt:

- Tempo (BPM): Für Synthwave typischerweise 80-110 BPM

- Tonart: Meist Moll für melancholische Stimmung

- Instrumentierung: Bestimmte Synth-Typen, Drumcomputer-Sounds

- Struktureller Aufbau: Typische Arrangement-Elemente des Genres

Nerd-Fact: Suno kann auch kontextbezogene Begriffe und Slang interpretieren – wenn du „Fat 808“ oder „Crunchy Beats“ eingibst, weiß das System, welche spezifischen Soundcharakteristiken gemeint sind.

2. Trainingsdaten: Der musikalische Wissensschatz der KI

Damit Suno überhaupt Musik erzeugen kann, musste die KI zunächst mit enormen Mengen an Musikdaten trainiert werden. Dieser Prozess ist die eigentliche Grundlage für die spätere Musikgenerierung.

Datenquellen und -umfang

Die Trainingsdaten umfassen Millionen von Musikstücken, darunter:

- Vollständige Songs verschiedenster Genres

- Isolierte Instrumentalspuren (Stems)

- MIDI-Dateien mit exakten Noten- und Rhythmusinformationen

- Songtexte und deren Alignment mit Melodien

- Strukturelle Metadaten (Verse, Chorus, Bridge etc.)

- Informationen zu Tonart, Tempo und Instrumentierung

Diese Daten stammen aus verschiedenen Quellen, darunter öffentlich zugängliche Musikdatenbanken, lizenziertes Material und eigens für das Training erstellte Aufnahmen.

Wie lernt die KI aus diesen Daten?

Beim Training analysiert das Modell diese Daten und erkennt Muster und Zusammenhänge:

- Welche Akkordfolgen sind in bestimmten Genres typisch?

- Wie sieht der rhythmische Aufbau eines Synthwave-Tracks aus?

- Welche melodischen Phrasierungen passen zu melancholischen Stimmungen?

- Wie wird Text in verschiedenen Gesangsstilen betont und rhythmisiert?

Das Modell entwickelt so ein „Verständnis“ für musikalische Zusammenhänge – nicht im menschlichen Sinne, sondern als statistische Wahrscheinlichkeiten und Muster in einem hochdimensionalen Vektorraum.

Nerd-Fact: Die Trainingssets für moderne KI-Musikmodelle umfassen oft über 20.000 Stunden Audiomaterial und Terabytes an Daten.

3. Modellarchitektur: Das „Gehirn“ der Musik-KI

Suno verwendet, wie viele moderne KI-Systeme, eine komplexe Modellarchitektur, die auf Transformern basiert – der gleichen Grundtechnologie, die auch hinter GPT, DALL-E und anderen KI-Systemen steckt.

Transformer-Modelle für Musik

Transformer eignen sich hervorragend für Musik, da sie:

- Langfristige Abhängigkeiten erfassen können (wichtig für musikalische Strukturen)

- Parallele Informationsverarbeitung ermöglichen (mehrere Instrumente gleichzeitig)

- Kontextbezogene Entscheidungen treffen können (was passt musikalisch zusammen?)

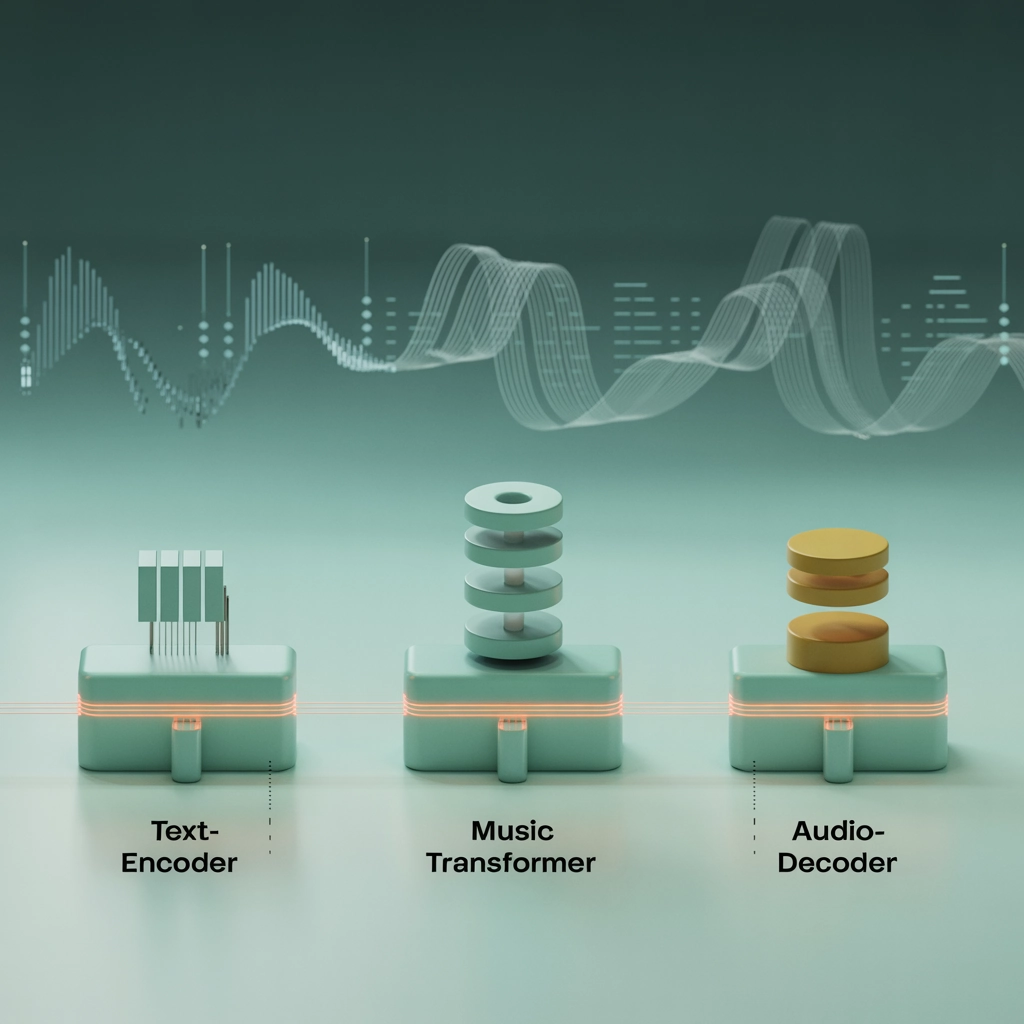

Das Modell besteht aus mehreren Komponenten:

- Text-Encoder: Verarbeitet deinen Prompt und erzeugt eine interne Repräsentation

- Music Transformer: Überführt diese Repräsentation in musikalische Strukturen

- Audio-Decoder: Wandelt die abstrakten musikalischen Strukturen in konkrete Audioformen um

Technische Pipeline bei Suno

Der Prozess läuft in etwa so ab:

- Der Prompt wird tokenisiert und durch den Text-Encoder geleitet

- Der Music Transformer erzeugt eine latente Repräsentation des gewünschten Songs

- Diese abstrakte Repräsentation wird in konkrete Noten, Rhythmen und Klangfarben übersetzt

- Der Audio-Decoder generiert daraus tatsächliche Audiodaten (Wellenformen)

Nerd-Fact: Die Modelle arbeiten autoregressiv – sie generieren die Musik Stück für Stück und beziehen dabei immer ein, was sie bereits erzeugt haben, um musikalische Konsistenz zu gewährleisten.

4. Audiogenerierung & Synthese: Klangerzeugung aus dem Nichts

Einer der faszinierendsten Aspekte ist, wie Suno tatsächlich die hörbaren Sounds erzeugt – denn hier entsteht aus mathematischen Modellen echter Klang.

Von Daten zu Klängen

Suno kombiniert zwei grundlegende Ansätze:

- Sample-basierte Synthese: Nutzt Elemente aus dem Trainingsdatensatz und modifiziert sie

- Generative Synthese: Erzeugt komplett neue Klänge basierend auf gelernten Klangcharakteristiken

Für jeden Instrumententyp und jede Stimme hat die KI gelernt, wie typische Klangmuster aussehen – sowohl im Zeit- als auch im Frequenzbereich.

Gesangssynthese: Die größte Herausforderung

Besonders beeindruckend ist Sunos Fähigkeit, überzeugenden Gesang zu erzeugen:

- Die KI analysiert, wie verschiedene Wörter gesungen (nicht gesprochen) klingen

- Sie versteht phonetische Eigenheiten und Artikulation beim Singen

- Sie kann Emotionen durch Vibrato, Betonung und Timbre vermitteln

- Sie passt die Gesangslinien an den musikalischen Kontext an

Die Ergebnisse sind oft so überzeugend, dass sie von menschlichem Gesang kaum zu unterscheiden sind – ein Meilenstein in der KI-Entwicklung.

Nahtlose Integration: Das „Stitching“

Ein kritischer Schritt ist das sogenannte „Stitching“ – das nahtlose Zusammenfügen verschiedener Songteile:

- Unterschiedliche Abschnitte (Verse, Chorus, etc.) werden teilweise separat generiert

- Spezielle Algorithmen sorgen für fließende Übergänge

- Die KI achtet auf harmonische und rhythmische Kontinuität

- Wiederholende Elemente werden erkannt und konsistent gehalten

Nerd-Fact: Moderne KI-Musikmodelle wie Suno arbeiten mit einer Abtastrate von bis zu 48kHz und einer Bittiefe von 24 Bit – das entspricht Studioqualität.

5. Automatischer Mix: Studioqualität auf Knopfdruck

Der letzte Schritt im Prozess ist der automatische Mix – quasi der digitale Toningenieur, der dem Song den letzten Schliff gibt.

Was der automatische Mix leistet

- Balancierung: Anpassung der Lautstärkeverhältnisse zwischen Instrumenten und Gesang

- EQ: Feinabstimmung der Frequenzbereiche für jeden Klangteil

- Kompression: Dynamikbearbeitung für mehr „Punch“ und Ausgewogenheit

- Effekte: Hinzufügen von Hall, Delay, Chorus etc. entsprechend dem gewünschten Genre

- Stereopositionierung: Platzierung der Instrumente im Stereofeld

Die KI hat gelernt, wie typische Mixe in verschiedenen Genres klingen und wendet dieses Wissen automatisch an.

Anpassung und Iteration

Suno erlaubt auch Anpassungen nach der ersten Generierung:

- Du kannst Varianten eines generierten Songs erstellen lassen

- Bestimmte Aspekte können durch zusätzliche Prompts verändert werden

- Die KI „merkt“ sich deine Präferenzen und kann sie in zukünftige Generationen einbeziehen

Nerd-Fact: In den neuesten Versionen kann Suno sogar grundlegende Mastering-Prozesse durchführen – also den Gesamtsound für verschiedene Wiedergabemedien optimieren.

Fazit: Die Zukunft der KI-Musikgenerierung

Was heute mit Suno möglich ist, hätte vor wenigen Jahren noch als Science-Fiction gegolten. Die Technologie entwickelt sich rasant weiter und wird immer ausgefeilter. In Zukunft können wir erwarten:

- Noch realistischere Gesangsstimmen mit größerer emotionaler Tiefe

- Feinere Kontrolle über einzelne Aspekte der Musikproduktion

- Interaktivere Modelle, die in Echtzeit auf Eingaben reagieren

- Bessere Integration in bestehende Musikproduktionswerkzeuge

Für Musiker, Content-Creator und Technik-Enthusiasten eröffnet dies völlig neue kreative Möglichkeiten – ob als Inspirationsquelle, als Produktionshilfe oder einfach als faszinierende Spielwiese.

Wenn du mehr über KI-Tools und ihre kreativen Anwendungen erfahren möchtest, schau gerne auf unserem YouTube-Kanal vorbei, wo wir regelmäßig die neuesten Technologien testen und erklären.

Bist du neugierig geworden? Hast du Suno oder ähnliche KI-Musiktools bereits ausprobiert? Teile deine Erfahrungen gerne in den Kommentaren – wir sind gespannt auf deine Entdeckungen im Bereich der KI-generierten Musik!

Schreibe einen Kommentar